نسل بعدی هوش مصنوعی (غلبه بر محدودیتهای LLMها)

مدل های زبانی بزرگ (LLM) تولید محتوا را خودکار میکنند، کارایی را بهبود میبخشند و سرمایهگذاریهای عمده را جذب میکنند. اما همچنان با مسائل سوگیری، توهم و تواناییهای استدلالی محدود، دست و پنجه نرم میکنند.

برای رفع این کاستی ها، موج بعد یا نسل بعدی هوش مصنوعی در حال ظهور است که دقت بیشتر، درک زمینه ای عمیق تر و یادگیری کارآمدتر را ارائه می دهد. در این مقاله، بررسی می کنیم که چگونه هوش مصنوعی نسل بعدی با ادغام فناوری های نوآورانه مانند پیشرفتهای زیر میتواند به هوش مصنوعی برای غلبه بر چالشهای فعلی و دستیابی به درک عمیقتر کمک کند:

- بازیابی نسل افزوده (RAG): اطلاعات را از منابع خارجی برای بهبود دقت بیرون می کشد.

- مدلهای چندوجهی: متن، تصاویر و دیگر انواع دادهها را با هم پردازش میکنند تا عملکرد گستردهتری داشته باشند.

- سیستمهای عصبی- نمادین (ترکیبی): برای تصمیمگیری بهتر، یادگیری عمیق را با استدلال ساختار یافته ترکیب کنید.

- محاسبات کوانتومی: محاسبات پیچیده را سرعت می بخشد و به طور بالقوه عملکرد هوش مصنوعی را تغییر می دهد.

- تراشه های نورومورفیک: کارایی مغز را برای بهبود قدرت پردازش و سازگاری تقلید کنید.

- هوش مصنوعی منبع باز: همکاری و نوآوری را تشویق می کند و باعث پیشرفت سریعتر می شود.

1. فراتر از تشخیص الگو : در حال تکامل به سمت هوش مصنوعی نسل بعدی

نسل بعدی هوش مصنوعی صرفاً بزرگ کردن پارامترها، سوگیری یا استدلال زمینه ای را به طور کامل حل نمی کند. محققان بر روی جبهه های مکمل تمرکز دارند:

نسل جدید هوش مصنوعی : پیشرفت های سریع و کاهش هزینه

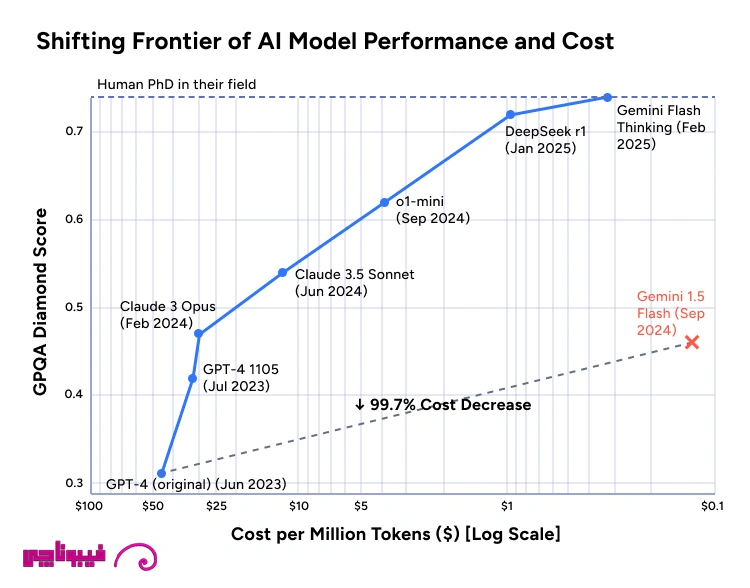

سرعت نوآوری در مدل های زبانی بزرگ (LLM) خیرهکننده بوده است و هر نسل جدید هم عملکرد و هم مقرون به صرفه بودن را بهبود میبخشد. نمودار زیر این تغییر را نشان میدهد و نشان میدهد که چگونه مدلهایی مانند Claude 3، GPT-4 و DeepSeek پیشرفتهای چشمگیری در توانایی استدلال داشتهاند، در حالی که هزینه هر میلیون توکن بهطور چشمگیری کاهش یافته است.

همانطور که در نمودار نشان داده شده است:

هزینههای کمتر، پذیرش گستردهتر: با مقرون به صرفهتر شدن هوش مصنوعی مولد، شرکتهای کوچکتر میتوانند زمانی که به فناوریهای بزرگ محدود شوند، به قابلیتهای مرزی دسترسی داشته باشند. نزدیک شدن به تخصص انسانی: مدلهایی مانند Claude 3 و Gemini Flash عملکرد تقریباً متخصصی را در کارهای تخصصی نشان میدهند که گاهی با متخصصان حوزه رقابت میکنند.

1.1 بازیابی-افزایش نسل (RAG)

به جای تکیه صرفاً بر داده های آموزشی ثابت، LLM ها می توانند پایگاه داده های خارجی یا منابع وب را در پرواز جستجو کنند. این به کاهش توهمات و به روز نگه داشتن پاسخ ها کمک می کند.

به عنوان مثال، رویکرد “self-RAG” Google DeepMind مدل هایی دارد که کیفیت محتوای بازیابی شده را منعکس می کند و به طور مکرر پرس و جوها را اصلاح می کند و توهمات را در کارهای پیچیده به حداقل می رساند.

1.2 یکپارچه سازی نمودارهای دانش

هنگامی که یک LLM با دادههای ساختار یافته نموداری دانش از مفاهیم و روابط جفت میشود، میتواند خروجیهای خود را در برابر یک منبع حقیقت تأیید کند. مطالعات اولیه نشان می دهد که ترغیب LLM ها با اطلاعات نمودار مربوطه به طور قابل توجهی دقت واقعی را بهبود می بخشد و پاسخ های بی معنی را کاهش می دهد.

1.3 مدل های چندوجهی

انسان ها اطلاعات دیداری، شنیداری و متنی را به طور یکپارچه ترکیب می کنند. سیستمهای هوش مصنوعی نسل بعدی همین کار را میکنند:

- CLIP، Flamingo، GPT-4V این مدلها از یادگیری متضاد برای تراز کردن متن و تصاویر در یک فضای معنایی مشترک استفاده میکنند و استدلال بصری را ممکن میسازد.

- انواع GPT-4o و Gemini 1.5 Pro Emerging از OpenAI و Google فراتر رفته و دادههای ویدیو، صدا یا حسگر را برای تشخیصهای صنعتی IoT و روباتیک پیشرفته پردازش میکنند.

1.4 هوش مصنوعی ترکیبی (عصبی + نمادین)

شبکه های عصبی صرفاً مبتنی بر داده اغلب با استدلال منطقی یا تفسیرپذیری دست و پنجه نرم می کنند. هوش مصنوعی ترکیبی LLM ها را با یک موتور نمادین که قوانین یا منطق صریح را اعمال می کند، متحد می کند. این رویکرد میتواند کمک کند تا اطمینان حاصل شود که خروجیها از مراحل استدلال منسجم پیروی میکنند و در صورت نیاز قابلیت توضیح را ارائه میدهند.

مزایای کلیدی هوش مصنوعی ترکیبی:

Symbolic Logic for Governance یا هوش مصنوعی نمادین به توسعه دهندگان اجازه می دهد تا قوانین، محدودیت ها یا دستورالعمل های نظارتی شناخته شده را به شکل ساختاریافته رمزگذاری کنند. سپس موتور نمادین میتواند خروجی یک LLM را زمانی که با منطق تعیین شده یا الزامات انطباق در تضاد باشد، تأیید یا لغو کند.

برنامهریزی پویا و استدلال چند مرحلهای

شبکههای عصبی در تشخیص الگو برتری دارند، اما اغلب در زنجیرهای کردن چندین مرحله منطق دچار تزلزل میشوند. با واگذاری برنامه ریزی چند مرحله ای به یک ماژول نمادین، سیستم می تواند با اطمینان بیشتری وظایف پیچیده را انجام دهد و از دنباله های غیرمنطقی “توهم” اجتناب کند.

توضیح پذیری و شفافیت

ترکیب یک شبکه عصبی جعبه سیاه با یک سیستم مبتنی بر قانون، لایه ای از قابلیت تفسیر را اضافه می کند. وقتی یک خروجی به چالش کشیده میشود، سازمانها میتوانند به «قوانین استدلال» موتور نمادین اشاره کنند تا روشن کنند که چگونه پاسخهای نهایی به دست آمدهاند.

مطالعه موردی: وسایل نقلیه خودران

بسیاری از سیستمهای خودران، ادراک عصبی (مثلاً تشخیص عابران پیاده و علائم راهنمایی و رانندگی) را با تصمیمگیری نمادین (ایستادن پشت چراغ قرمز، پیروی از قوانین محلی) ترکیب میکنند. این هم افزایی سازگاری یادگیری عمیق را با منطق مبتنی بر قانون متعادل می کند.

1.5 کارایی یادگیری شبیه انسان

LLM های فعلی به مجموعه داده های عظیم و آموزش گسترده نیاز دارند. محققانی مانند Yann LeCun «هوش مصنوعی هدفمحور» را پیشنهاد میکنند (مثلاً، معماری پیشگوی تعبیه مشترک، JEPA) که در آن هوش مصنوعی از طریق مشاهده، پیشبینی و آزمایش یاد میگیرد (شبیه به چگونگی دستیابی انسان به عقل سلیم). چنین روشهایی میتوانند به مدلها اجازه دهند خود را بدون بازآموزی مکرر و در مقیاس کامل بهروزرسانی کنند. این در عمل چگونه می تواند به نظر برسد؟

روشهای فرا یادگیری و چند شات

تکنیکهای مدرن «چند شات» یا «فرا-یادگیری» یک مدل را قادر میسازد تا از نمونههای حداقلی تعمیم یابد و نحوه یادگیری سریع انسان از دادههای محدود را تقلید کند.

به روز رسانی مستمر

به جای آموزش مجدد کل مدل، سیستم ها می توانند بخش هایی از حالت داخلی خود را (مانند حافظه کاری) اصلاح کنند تا با اطلاعات جدید به محض رسیدن، سازگار شوند.

کاهش هزینه های آموزشی

آموزش LLM های بزرگ از ابتدا نیازمند منابع است. یادگیری افزایشی و کارآمدتر هزینه های سخت افزار و انرژی را کاهش می دهد.

عقل سلیم قویتر

با آموزش به روشی نزدیکتر به یادگیری رشدی انسان (مشاهده محیط، پیشبینی، آزمایش فرضیه)، مدلها ممکن است در طول زمان استدلال «عقل سلیم» قویتری ایجاد کنند.

1.6 عوامل خودمختار مبتنی بر LLM

فراتر از ادغام نمودارهای دانش، منطق نمادین یا داده های چندوجهی، یک مرز به سرعت در حال ظهور، توسعه عوامل مستقل مبتنی بر LLM است – که گاهی اوقات “عوامل مولد” نامیده می شود. این سیستمها از مدلهای زبان قدرتمند (مانند GPT-4 یا Claude) استفاده میکنند، اما استفاده از ابزار، حافظه بلندمدت و حلقههای برنامهریزی تکراری را برای حل وظایف پیچیدهتر با حداقل نظارت انسانی اضافه میکنند.

اجرای وظیفه خودگردان

در پروژههایی مانند Auto-GPT و BabyAGI ، LLM نه تنها پاسخها را تولید میکند، بلکه زنجیرهای از وظایف فرعی را «برنامهریزی» و «اجرا» میکند و به ابزارهای خارجی (مثلاً مرورگرهای وب، APIها یا پایگاههای داده) در صورت نیاز دسترسی پیدا میکند. این میتواند توانایی هوش مصنوعی را برای رسیدگی به اهداف طولانی و چند مرحلهای که فراتر از یک الگوی سریع و پاسخ واحد است را بهطور اساسی افزایش دهد.

حافظه و ماندگاری زمینه

در حالی که LLMهای استاندارد از پنجرههای زمینه محدود رنج میبرند، چارچوبهای عامل مستقل، حافظههای تخصصی را (اغلب در پایگاههای داده برداری) برای حفظ و بازیابی اطلاعات در طول زمان فراهم میکنند. این امر از تداوم بیشتر «عاطفی» پشتیبانی میکند و هوش مصنوعی را قادر میسازد تا تصمیمات قبلی را مجدداً بررسی کند، از اشتباهات درس بگیرد و دادههای جدید را بدون بازآموزی کامل مدل ترکیب کند.

برنامه دنیای واقعی

با توجه به برنامه های کاربردی دنیای واقعی، عوامل هوش مصنوعی مستقل را می توان در عملکردها و صنایع متعدد به کار برد. در هوش تجاری، آنها میتوانند به طور مستقل دادههای بازار را جمعآوری و تجزیه و تحلیل کنند، بینشهای بیدرنگ ایجاد کنند و اقداماتی را به مدیران توصیه کنند. به طور مشابه، در مهندسی نرمافزار ، فراتر از تولید کد، با تکرار نتایج آزمایش و ادغام با ابزارهایی مانند GitHub، به اشکالزدایی و refactoring کمک میکنند. علاوه بر این، به عنوان دستیار مجازی ، آنها به طور یکپارچه بازیابی دانش، زمانبندی رویداد، و تهیه پیشنویس ایمیل، سادهسازی گردش کار و افزایش بهرهوری را با هم ترکیب میکنند.

چالش ها و فرصت ها

در حالی که این سیستمهای عامل اتوماسیون بیسابقهای را ارائه میکنند ، اما نگرانیها در مورد همسویی، ایمنی و مسئولیتپذیری را تشدید میکنند . اشتباهات می توانند در چندین مرحله خود هدایت شونده ترکیب شوند و اهداف نادرست می توانند منجر به نتایج ناخواسته شوند. تحقیقات برای ادغام نردههای محافظ قوی (مانند هوش مصنوعی ترکیبی) و نظارت پیشرفته ادامه دارد تا اطمینان حاصل شود که عوامل در محدودههای اخلاقی و مقرراتی عمل میکنند.

آینده نگری

کارشناسان پیشبینی میکنند که عوامل مستقل مبتنی بر LLM به زودی میتوانند جریانهای کاری پیچیده را تنظیم کنند و با تیمهای انسانی مانند «کارمندان دیجیتالی» کوچکتر همکاری کنند. همراه با پیشرفتهایی در زمینه دانش بیدرنگ (real-time) ، LLMهای عامل ممکن است وظایف را با محدودیتهای کمتری انجام دهند و به تدریج به هوش عمومیتر نزدیک شوند؛ البته با نظارت دقیق و اصلاح مداوم.

1.7 چالش های پذیرش هوش مصنوعی: موانع کلیدی برای غلبه بر

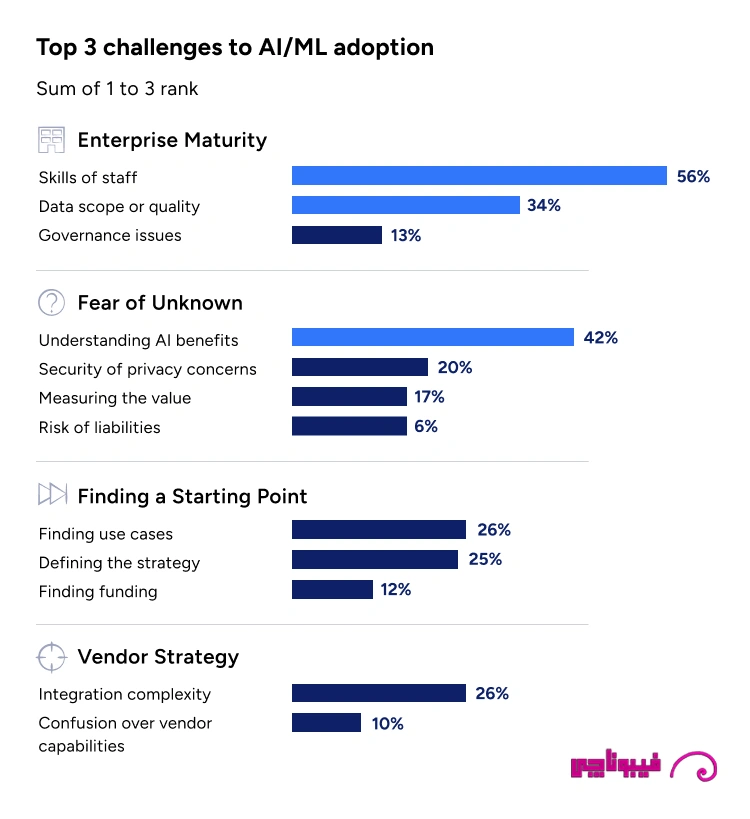

در حالی که پذیرش هوش مصنوعی در سراسر صنایع به شتاب خود ادامه می دهد، سازمان ها با موانع مستمری روبرو هستند که استقرار در مقیاس کامل را محدود می کند. بر اساس تحقیقات گارتنر، چالش های اصلی عبارتند از:

- شکاف های بلوغ سازمانی، مانند کمبود کارکنان ماهر و نگرانی در مورد دامنه داده ها و حاکمیت.

- ترس از ناشناخته بودن، با عدم اطمینان در مورد مزایای هوش مصنوعی، خطرات امنیتی، و اندازه گیری ROI.

- یافتن نقطه شروع، به ویژه در شناسایی موارد استفاده واضح و تامین بودجه.

- پیچیدگی فروشنده، از جمله چالش های یکپارچه سازی و سردرگمی در مورد قابلیت های فروشنده.

1.8 پایداری و عمق اخلاقی

هوش مصنوعی سبز:

آموزش با پارامتر کارآمد (LoRA، QLoRA ) و رویکردهای کوانتیزه شده (به عنوان مثال، LLaMA 3 متا) می تواند مصرف انرژی را تا 70٪ کاهش دهد بدون اینکه به شدت دقت را کاهش دهد.

چارچوبهای اخلاقی:

سازمانها به طور فزایندهای نیاز به ایجاد چارچوبهای کیفیت داده قوی دارند، به عنوان مثال با اتخاذ دستورالعملهایی مانند چارچوب مدیریت ریسک هوش مصنوعی NIST یا دستورالعمل مسئولیت AI اتحادیه اروپا، که اغلب با ابزارهایی مانند هوش مصنوعی BiasBusters برای بررسی سوگیری در زمان واقعی جفت میشوند.

2. چشم انداز آینده نگر در هوش مصنوعی نسل بعدی

2.1 هوش مصنوعی پیشرفته کوانتومی

معماریهای کوانتومی-کلاسیک ترکیبی میتوانند با بهینهسازی ترکیبی در لجستیک یا کشف دارو مقابله کنند. پروژه هایی که Qiskit IBM را با LLM های پیشرفته مرتبط می کند در مراحل اولیه تحقیقاتی هستند.

2.2 تراشه های نورومورفیک

Loihi 2 اینتل از شبکههای عصبی spiking برای استنتاج فوقالعاده کارآمد استفاده میکند، که به طور بالقوه بهبود ۱۰۰× در مصرف انرژی را ارائه میکند، که برای استقرار زمان واقعی یا لبهای ضروری است.

2.3 Open-Source Momentum (منبع باز)

جوامعی مانند Mistral و EleutherAI (با مدلهایی مانند Pythia ) با ارائه کدها و وزنهای شفاف و با کیفیت بالا و ایجاد نوآوری و مسئولیتپذیری در اکوسیستم، سلطه مالکانه را به چالش میکشند.

2.4 تحولات بسیار اخیر

- Claude 3 به عنوان یک رقیب قوی برای GPT-4 در برخی وظایف، به ویژه کدنویسی و استدلال خلاق ظاهر می شود.

- Llama 3 و DeepSeek Coder شکاف بین سیستم های منبع باز و اختصاصی را کاهش می دهند.

- چارچوبهای ارزیابی جدید: محققان فراتر از معیارهای ساده حرکت میکنند و بر آزمایشهای متخاصم و وضوح زنجیره فکر تمرکز میکنند.

- خود تکاملیافته بازگشتی: آزمایشهای اولیه به مدلها اجازه میدهد تا پیشرفتهایی را در معماریهای خود ارائه دهند.

3. توصیه های استراتژیک برای رهبران کسب و کار

از LLM ها استفاده کنید، اما حفاظ ها را اضافه کنید.

در جریانهای کاری پرمخاطره (مانند گزارشدهی مالی یا مراقبت از بیمار) از بازبینی انسانی و محدودیتهای حوزه برای گرفتن توهم یا سوگیری استفاده کنید.

LLM ها را با ابزارهای دیگر ترکیب کنید.

چارچوب های ارکستراسیون مدل می توانند بین LLM های تخصصی، نمودارهای دانش، یا خطوط لوله مبتنی بر RAG جابجا شوند تا دقت را به حداکثر برسانند. این رویکرد دانش را به روز نگه می دارد و اتکا به آموزش استاتیک را کاهش می دهد.

TinyML و راهکارهای روی دستگاه را بپذیرید.

این به ویژه برای سناریوهای IoT و محاسبات رایانش لبه مرتبط است.

نظارت بر بدهی اخلاقی

دقیقاً همانطور که بدهی های فنی در صورت عدم رسیدگی انباشته می شود، زمانی که تعصبات، شکاف های حریم خصوصی یا عدم انطباق مقررات حل نشده باقی می مانند، «بدهی اخلاقی» افزایش می یابد. ممیزی بدهی هوش مصنوعی می تواند این مسائل را زود تشخیص دهد و از اعتبار برند محافظت کند.

اجرای GenAI Ops (MLOps 2.0)

بررسی خطوط لوله (Pipelines) در یادگیری ماشین باید دارای مراحل تولید افزوده شده بازیابی، «نقاط بازرسی» نمادین و گزارش گیری قوی برای تفسیرپذیری باشد. این امر حاکمیت سرتاسری را از آموزش مدل تا تولید تضمین میکند.

کارکنان سازمان خود

را در زمینه اصول هوش مصنوعی آموزش دهید. بر اساس تجربه پیادهسازی هوش مصنوعی در صنایع مختلف، شاهدیم که تیمهایی با سواد دادهای قوی بهتر از ابزارهای هوش مصنوعی جدید استفاده میکنند و سریعتر مشکلات را شناسایی میکنند.

منعطف و فروشنده-اگنوستیک بمانید.

چشم انداز هوش مصنوعی به سرعت در حال تکامل است. یک معماری فروشنده-اگنوستیک به شما امکان می دهد مدل های جدید (چند وجهی، MoE یا کوانتومی تقویت شده) را در حالی که توسعه داده و رشد می کنند بدون دوباره کاری قابل توجهی تعویض کنید.

برای الزامات قانونی و اخلاقی آماده شوید.

ابزارهایی مانند BiasBusters AI یا چارچوبهای NIST و اتحادیه اروپا به شما کمک میکنند تا به طور فعالانه مطابقت را حفظ کنید، بهویژه وقتی مقررات جهانی سختتر میشوند.

4. مسیر پیش رو

LLM ها علیرغم ایراداتشان، چشمان ما را به پتانسیل تحول آفرین هوش مصنوعی باز کرده اند. طی پنج تا ده سال آینده، پیشرفتها در بازیابی، پایهگذاری دانش و ادغام چندوجهی میتواند سیستمهایی را به همراه داشته باشد که واقعاً زمینه را درک میکنند، با اطمینان بیشتری استدلال میکنند و به روز میمانند. معماریهای ترکیبی همچنین ممکن است قابلیت توضیح را افزایش دهند و به شرکتها و تنظیمکنندهها به طور یکسان به خروجیهای هوش مصنوعی در حوزههای حساس اعتماد کنند.

از نظر عملی می توان انتظار داشت:

- نفوذ عمیقتر راهحلهای مبتنی بر LLM، از رباتهای تولیدی که دستورالعملهای متنی و نشانههای بصری را تفسیر میکنند تا سیستمهای مراقبتهای بهداشتی که دادههای بیمار را ترکیب میکنند.

- سرمایه هنگفت خصوصی و عمومی برای ادامه تقویت تحقیق و توسعه هوش مصنوعی. رقابت بین ایالات متحده، اتحادیه اروپا و چین برای پیشرو در هوش مصنوعی، سرمایهگذاری در زیرساختهای محاسباتی، تراشههای تخصصی و مدلهای نسل بعدی را به همراه خواهد داشت.

- همگرایی هوش مصنوعی با رباتیک و اینترنت اشیا، زیرا مدل های زبانی بزرگ با حسگرها، محیطهای فیزیکی و دادههای بیدرنگ ادغام میشوند تا عملیات مستقلتر انجام شود.

- مقررات سختگیرانهتر که مستلزم شفافیت، کنترل جانبداری و حمایت از مصرفکننده است، محصولات جدید «هوش مصنوعی مسئول» و خدمات انطباق را تحریک میکند.

برای رهبران کسب و کار، این امر دو جنبه ضروری است:

- استفاده از قدرت LLM های امروزی برای دستاوردهای فوری، و چابک ماندن برای جهش های آینده نزدیک در معماری هوش مصنوعی.

- کسانی که تخصص انسانی را با ابزارهای هوش مصنوعی پیشرفته به بهترین نحو ترکیب می کنند، مرز نوآوری را در دهه آینده مشخص خواهند کرد.

جمع بندی

مدل های زبانی بزرگ LLMs جرقهای انقلاب هوش مصنوعی مولد، جذب سرمایهگذاری بیسابقه و دستاوردهای نویدبخش بهرهوری در بخشها شده است. با این حال، آنها در هسته اصلی، پیشبینیکنندههای آماری هستند که درک درستی ندارند. توهمات، سوگیری ها، و دانش ایستا بر نیاز به نظارت دقیق و راه حل های تکمیلی مانند تولید تقویت شده با بازیابی، هوش مصنوعی ترکیبی و تنظیم دقیق یا فاین تیون هوش مصنوعی مداوم تأکید می کند.

شرکتهایی که اکنون LLM را اتخاذ میکنند، میتوانند ارزش فوری را تضمین کنند (به شرط اینکه نردههای محافظ قوی، یکپارچهسازی دامنه و بررسیهای انسانی کامل را اجرا کنند. در همین حال، نسل جدید هوش مصنوعی احتمالاً دارای سیستمهایی خواهد بود که به طور موثر یاد میگیرند، دادههای چندوجهی را یکپارچه مدیریت میکنند و استدلال شفاف ارائه میدهند. با درک محدودیتهای فعلی و جهتگیریهای در حال ظهور، سازمانها میتوانند استراتژیهای خود را در آینده اثبات کنند و از هوش مصنوعی به عنوان یک متحد قدرتمند در صنایع مختلف استفاده کنند. سفر تازه ای شروع شده است.